Les universitaires du début du XXe siècle spécialisés en sciences humaines, les critiques, conservateurs et commissaires d’expositions ont accès à une quantité de médias visuels sans précédent — beaucoup plus qu’il ne leur serait possible d’étudier, ni même simplement visualiser ou encore rechercher.

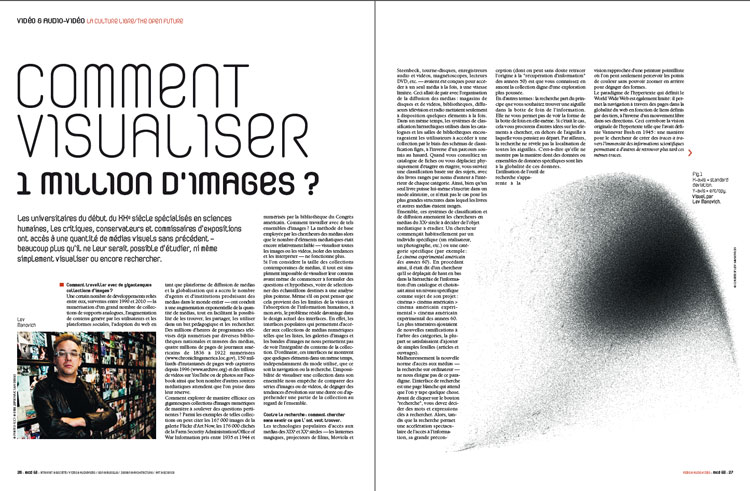

Manga / montage (close-ups). Lev Manovich & Jeremy Douglass, 2010. Photo: D.R. / Courtesy Lev Manovich

Comment travailler avec de gigantesques collections d’images?

Une certain nombre de développements reliés entre eux, survenus entre 1990 et 2010 — la numérisation d’un grand nombre de collections de supports analogues, l’augmentation de contenu généré par les utilisateurs et les plateformes sociales, l’adoption du web en tant que plateforme de diffusion de médias et la globalisation qui a accru le nombre d’agents et d’institutions produisant des médias dans le monde entier — ont conduit à une augmentation exponentielle de la quantité de médias, tout en facilitant la possibilité de les trouver, les partager, les utiliser dans un but pédagogique et les rechercher. Des millions d’heures de programmes télévisés déjà numérisés par diverses bibliothèques nationales et musées des médias, quatre millions de pages de journaux américains de 1836 à 1922 numérisées (www.chroniclingamerica.loc.gov), 150 milliards d’instantanés de pages web capturées depuis 1996 (www.archive.org) et des trillons de vidéos sur YouTube ou de photos sur Facebook ainsi que bon nombre d’autres sources médiatiques attendent que l’on puise dans leur réserve.

Comment explorer de manière efficace ces gigantesques collections d’images numériques de manière à soulever des questions pertinentes ? Parmi les exemples de telles collections on peut citer les 167 000 images de la galerie Flickr d’Art Now, les 176 000 clichés de la Farm Security Administration/Office of War Information pris entre 1935 et 1944 et numérisés par la bibliothèque du Congrès américain. Comment travailler avec de tels ensembles d’images ? La méthode de base employée par les chercheurs des médias alors que le nombre d’éléments médiatiques était encore relativement faible — visualiser toutes les images ou les vidéos, isoler des tendances et les interpréter — ne fonctionne plus.

Si l’on considère la taille des collections contemporaines de médias, il tout est simplement impossible de visualiser leur contenu avant même de commencer à formuler des questions et hypothèses, voire de sélectionner des échantillons destinés à une analyse plus pointue. Même s’il on peut penser que cela provient des les limites de la vision et l’absorption de l’information humaines, à mon avis, le problème réside davantage dans le design actuel des interfaces. En effet, les interfaces populaires qui permettent d’accéder aux collections de médias numériques telles que les listes, les galeries d’images et les bandes d’images ne nous permettent pas de voir l’intégralité du contenu de la collection. D’ordinaire, ces interfaces ne montrent que quelques éléments dans un même temps, indépendamment du mode utilisé, que ce soit la navigation ou la recherche. L’impossibilité de visualiser une collection dans son ensemble nous empêche de comparer des séries d’images ou de vidéos, de dégager des tendances d’évolution sur une durée ou d’appréhender une partie de la collection au regard de l’ensemble.

Contre la recherche : comment chercher sans savoir ce que l’ont veut trouver.

Les technologies populaires d’accès aux médias des XIXe et XXe siècles — les lanternes magiques, projecteurs de films, Moviola et Steenbeck, tourne-disques, enregistreurs audio et vidéos, magnétoscopes, lecteurs DVD, etc. — avaient été conçues pour accéder à un seul média à la fois, à une vitesse limitée. Ceci allait de pair avec l’organisation de la diffusion des médias : magasins de disques et de vidéos, bibliothèques, diffuseurs télévision et radio mettaient seulement à disposition quelques éléments à la fois. Dans un même temps, les systèmes de classification hiérarchiques utilisés dans les catalogues et les salles de bibliothèques encourageaient les utilisateurs à accéder à une collection par le biais des schémas de classification figés, à l’inverse d’un parcours soumis au hasard. Quand vous consultiez un catalogue de fiches ou vous déplaciez physiquement d’étagère en étagère, vous suiviez une classification basée sur des sujets, avec des livres rangés par noms d’auteur à l’intérieur de chaque catégorie. Ainsi, bien qu’un seul livre puisse lui-même s’inscrire dans un mode aléatoire, ce n’était pas le cas pour les plus grandes structures dans lequel les livres et autres médias étaient rangés.

Ensemble, ces systèmes de classification et de diffusion amenaient les chercheurs en médias du XXe siècle à décider de l’objet médiatique à étudier. Un chercheur commençait habituellement par un individu spécifique (un réalisateur, un photographe, etc.) ou une catégorie spécifique (par exemple : Le cinéma expérimental américain des années 60). En procédant ainsi, il était dit d’un chercheur qu’il se déplaçait de haut en bas dans la hiérarchie de l’information d’un catalogue et choisissait ainsi un niveau spécifique comme sujet de son projet : cinéma > cinéma américain > cinéma américain expérimental > cinéma américain expérimental des années 60. Les plus téméraires ajoutaient de nouvelles ramifications à l’arbre des catégories, la plupart se satisfaisaient d’ajouter de simples feuilles (articles et ouvrages).

Malheureusement la nouvelle norme d’accès aux médias — la recherche sur ordinateur — ne nous éloigne pas de ce paradigme. L’interface de recherche est une page blanche qui attend que l’on y tape quelque chose. Avant de cliquer sur le bouton « recherche », vous devez décider des mots et expressions clés à rechercher. Alors, tandis que la recherche permet une accélération spectaculaire de l’accès à l’information, sa grande préconception (dont on peut sans doute retracer l’origine à la « récupération d’information » des années 50) est que vous connaissez en amont la collection digne d’une exploration plus poussée.

En d’autres termes : la recherche part du principe que vous souhaitez trouver une aiguille dans la botte de foin de l’information. Elle ne vous permet pas de voir la forme de la botte de foin en elle-même. Si c’était le cas, cela vous procurera d’autres idées sur les éléments à chercher, en dehors de l’aiguille à laquelle vous pensiez au départ. Par ailleurs, la recherche ne révèle pas la localisation de toutes les aiguilles. C’est-à-dire qu’elle ne montre pas la manière dont des données ou ensembles de données spécifiques sont liés à la globalité de ces données. L’utilisation de l’outil de recherche s’apparente à la vision rapprochée d’une peinture pointilliste où l’on peut seulement percevoir les points de couleur sans pouvoir zoomer en arrière pour dégager des formes.

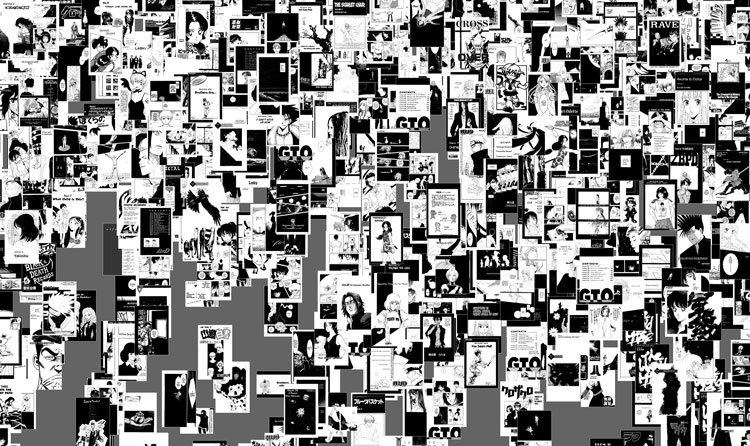

Kingdom Hearts II (videogame transversal). William Huber & Lev Manovich, 2009 / Kingdom Hearts II (Square-Enix Inc., 2005). Photo: D.R.

Le paradigme de l’hypertexte qui définit le World Wide Web est également limité : il permet la navigation à travers des pages dans la globalité du web en fonction de liens définis par des tiers, à l’inverse d’un mouvement libre dans ses directions. Ceci corrobore la vision originale de l’hypertexte telle que l’avait définie Vannevar Bush en 1945 : une manière pour le chercheur de créer des traces à travers l’immensité des informations scientifiques permettant à d’autres de retrouver plus tard ces mêmes traces.

Sur la base de mon étude sur quelques unes des plus grandes collection de médias en ligne disponibles aujourd’hui telles qu’europeana.org, archive.org, les collections numériques de la bibliothèque du Congrès américain et artstor.org, je distingue une interface type qui propose aux utilisateurs de naviguer de manière linéaire à travers une collection ou par le biais de catégories, de tags thématiques et d’effectuer une recherche en utilisant des métadonnées enregistrées pour chaque objet médiatique. Dans chacun des cas, les catégories, les tags et les métadonnées ont été insérés par les archivistes (aucun des sites que j’ai visité n’offrait des tags générés par les utilisateurs). De ce fait, lorsqu’un internaute accède aux collections institutionnelles de médias par le biais de leurs sites, il peut uniquement se déplacer selon un nombre de trajectoires déterminées par la taxinomie de la collection et les types de métadonnées employées pour décrire les données.

Par contraste, lorsqu’on observe une scène de la vie réelle en direct, avec ses yeux, on peut regarder dans tous les sens. Ceci permet de distinguer rapidement divers schémas, structures et liens. Imaginez, par exemple, que vous tourniez au coin d’une rue et que vous ayez dans votre champ de vision une place ouverte avec des passants, des cafés, des voitures, des arbres, des panneaux publicitaires, des vitrines de magasins et autres éléments… Vous pourriez rapidement détecter et suivre une multitude de motifs qui changent de manière dynamique sur la base d’une information visuelle et sémantique : des voitures se déplaçant le long de lignes parallèles, des maisons peintes de couleur similaire, des gens qui suivent le cours de leur trajectoire et d’autres en train de parler, des visages étranges, des vitrines qui se démarquent du reste, etc.

Nous avons besoin de techniques similaires qui nous permettent d’observer de vastes « univers de médias » et de détecter rapidement les tendances pertinentes. Ces techniques se doivent d’opérer à une vitesse bien supérieure à celle du visionnage (des médias basé sur le temps réel). Alternativement, elles doivent utiliser des images fixes. Je devrais pouvoir visualiser une information importante concernant un million de photos dans le temps habituellement requis pour visionner une seule image. Ces techniques se doivent de compresser les gigantesques univers de médias en « paysages » de médias plus petits et observables, compatibles avec la capacité humaine à traiter l’information. En même temps, elles doivent pouvoir conserver assez de détails issus des images, des vidéos, des sons ou des expériences interactives pour permettre une étude des tendances subtils au sein des données.

Visualisation des médias

Les limites des interfaces type des collections de médias en ligne valent aussi pour les interfaces des bureaux d’ordinateurs et des applications de téléphones portables qui permettent de visionner, cataloguer et sélectionner tout comme les sites qui hébergent des médias. Il en va de même pour les sites de collection spécialisés, les gestionnaires de médias et les sites d’hébergement permettant aux utilisateurs de naviguer et de rechercher des images et des vidéos et d’afficher les résultats dans différents formats. Leur utilité en tant qu’outils de recherche reste cependant très limitée. Des applications d’ordinateurs telles qu’iPhoto, Picasa, Adobe Bridge et des sites de partage d’images comme Flickr et Photobucket ne peuvent montrer que des images dans un nombre limité de formats fixes — généralement une grille à deux dimensions, une bande linéaire, un diaporama et, dans certains cas, une vue cartographiée (des photos superposées sur la carte du monde). Les images sont habituellement classées par date de téléchargement; pour afficher des photos dans un ordre différent, l’utilisateur doit passer du temps à ajouter de nouvelles métadonnées à toutes les images. Il ne peut organiser les images automatiquement selon leurs propriétés visuelles ou leurs relations sémantiques, ni comparer des collections susceptibles de contenir des centaines de milliers d’images ajoutées les unes aux autres, ni utiliser des techniques de visualisation d’informations afin d’explorer les tendances à travers des séries d’images.

Les outils graphiques et de visualisation — Google Docs Excel, Tableau, Many Eyes et autres logiciels graphiques et feuilles de calcul — offrent un éventail de techniques de visualisation conçu pour montrer des données. Mais ces outils ont eux aussi leurs limites. Un principe clé qui sous-tend la création de graphiques et de visualisation de l’information est la représentation de données à l’aide de points, de barres, de lignes et autres représentations archaïques Ce principe est resté immuable entre les premiers graphiques statistiques du début du XIXe siècle et les logiciels contemporains de visualisation interactive, qui peuvent opérer avec de grands ensembles de données. Bien que ces représentations indiquent clairement les relations dans un ensemble de données, elles cachent aussi les objets derrière les données de l’utilisateur. S’il est parfaitement adapté à de nombreux types de données, dans le cas d’images et de vidéos, ce modèle devient un sérieux obstacle. Par exemple, un diagramme 2D montrant une répartition des notes dans une classe avec chaque élève représenté par un point remplit son objectif, mais l »utilisation du même type de graphique pour représenter les tendances stylistiques au cours de la carrière d’un artiste à travers des points est plus limitée si nous ne pouvons visualiser les œuvres d’art.

Depuis 2008, mon projet Software Studies Initiative a mis au point des techniques visuelles qui associent la force des applications de visionnage à celle des applications de graphisme et de visualisation. Comme ces derniers, elles génèrent des graphiques qui montrent les relations et les tendances dans un groupe de données. Cependant, alors que logiciels qui créent des diagrammes peuvent seulement afficher les données sous forme de points, de lignes ou autres graphismes archaïques, notre logiciel peut montrer toutes les images d’une collection superposées sur un graphique. Nous appelons cette méthode la visualisation de médias (ou mediavis).

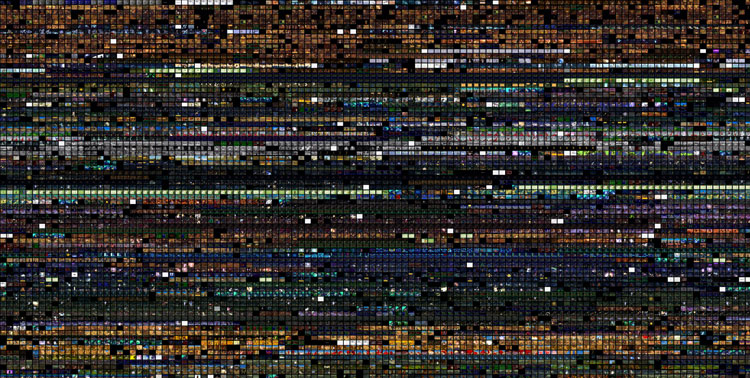

Mapping Time. Jeremy Douglass & Lev Manovich, 2009. Couvertures des différentes éditions du Time magazine par ordre de publication de 1923 à l’été 2009. Nombre de couvertures utilisées au total : 4535.

Une visualisation de l’information type consiste à d’abord traduire le monde en nombres et ensuite à visualiser les relations entre ces nombres. En revanche, la visualisation des médias se traduit par un ensemble d’images dans une représentation visuelle, qui peut révéler des tendances parmi les images. En bref, les images sont converties en images. Les deux visualisations de la même série de données exposées ci-après illustrent les différences entre infovis (visualisation d’informations) et mediavis (visualisation de médias). Les deux visualisations utilisent la technique familière du tracé de dispersion de points. Cependant la deuxième ajoute des images sur les points. La première visualisation montre la distribution des données, la seconde nous permet de comprendre ce qui se trouve derrière les points.

Les données utilisées pour ces visualisations sont 1.074.790 pages de mangas (bande dessinée japonaise). La première visualisation représente chaque page par un point. La deuxième visualisation utilise des copies de pages réduites à la place des points. Pour produire ces visualisations, nous avons mesuré un certain nombre de caractéristiques visuelles de chaque page: le contraste, le nombre de lignes, les propriétés de la texture, etc. Nous utilisons ensuite une des mesures pour placer les données sur l’axe des X, alors qu’une autre mesure est utilisée pour placer des données sur l’axe des Y. Cette méthode nous permet d’organiser les images selon leurs caractéristiques visuelles par rapport à deux dimensions.

Dans cette visualisation, les pages de la partie inférieure de la visualisation sont les plus graphiques et ont le moins de détails et de texture. Les pages en haut à droite possèdent une grande quantité de détail et de texture. Les pages au contraste plus élevé sont sur la droite, tandis que les pages au contraste le plus faible sont sur la gauche. Entre ces quatre extrêmes, nous trouvons chaque variation stylistique possible. Pour rendre tout cela plus facile à voir, nous avons inclus deux gros plans des parties inférieures et supérieures.

Que nous enseigne cette visualisation ? Elle suggère que notre concept fondamental de «style» n’est pas forcément approprié, nous considérons ensuite les grands ensembles de données culturelles. Le concept présuppose que nous puissions diviser d’un ensemble d’artéfacts culturels en un petit nombre de catégories distinctes. Dans le cas de notre ensemble d’un million de pages, nous constatons que les variations graphiques sont quasiment infinies. Si nous essayions de diviser cet espace en catégories stylistiques distinctes, une telle tentative deviendrait arbitraire. La visualisation distingue également les choix graphiques les plus couramment utilisés par les artistes de manga (dans la partie centrale du « nuage » de pages) et ceux semble-t-il plus rarement utilisés (en bas et à gauche).

Nos techniques de visualisation de médias peuvent être utilisés indépendamment ou en combinaison avec l’étude de l’image numérique. L’étude de l’image numérique est conceptuellement semblable à l’analyse automatique de textes déjà largement utilisée dans les sciences humaines numériques. L’analyse de texte consiste à extraire automatiquement différentes statistiques du contenu de chaque texte au sein d’une collection, comme les fréquences d’utilisation, la longueur et la position des mots, la longueur des phrases, les fréquences d’utilisation des noms et des verbes etc. Ces statistiques (appelés « caractéristiques » en sciences de l’informatique) sont ensuite utilisées pour étudier les tendances dans un texte unique et les relations entre des genres littéraires, des textes, etc.

De même, nous pouvons utiliser le traitement de l’image numérique pour calculer les statistiques de diverses propriétés visuelles des images : la luminosité et la saturation moyenne, le nombre et les propriétés des formes, le nombre d’arêtes et de leurs orientations, les couleurs-clés et ainsi de suite. Ces fonctionnalités peuvent ensuite être utilisées pour des études similaires — par exemple, l’analyse des différences visuelles entre les nouvelles photographies dans plusieurs magazines ou entre les photographies de presse de différents pays, les changements de style visuel au cours de la carrière d’un photographe ou l’évolution de la photographie de presse en général au cours du XXe siècle. Nous pouvons également les utiliser de manière plus élémentaire — pour l’exploration initiale de n’importe quelle grande collection d’images.

Lev Manovich

publié dans MCD #68, « La culture du libre », sept. / nov. 2012

Lev Manovich est un théoricien de l’étude des médias et des sciences humaines numériques. Il est professeur au département des arts visuels de l’Université de Californie – San Diego (UCSD) où il enseigne l’art numérique, l’histoire et la théorie de la culture numérique. Il dirige également le Software Studies Initiative au California Institute for Telecommunications and Information Technology (CALIT2). Fondé en 2007, ce laboratoire mène des recherches sur un nouveau paradigme d' »analytiques culturel » (cultural analytics); terme inventé par Manovich pour désigner l’utilisation de méthodes de calcul relatives à l’analyse d’ensembles massifs de données et de flux culturels. L’objectif du Software Studies Initiative est de développer des techniques et des logiciels libres, en les appliquant progressivement à des groupes d’image et de vidéo de plus en plus grands afin de mieux comprendre le fonctionnement de la culture.